Wer nicht auf die “Dark Side of the Moon” reisen möchte sollte bei der Auswertung von großen Datenbeständen sich nicht auf Tools wie Excel verlassen. Harald Weimer von Talend erklärt, warum er das nicht für eine gute Idee hält.

Nach einer Studie der University of Southern California betrug die Gesamtheit der auf Speichergeräten abgelegten digitalen Informationen noch vor nicht einmal zehn Jahren etwa 300 Exabyte. Zur Veranschaulichung: Das ist der Speicherplatz von 400 Mrd. CD-ROMs.

Wir haben in den vergangenen zehn Jahren jedoch in vielen Bereichen umfassende Veränderungen erlebt, die uns ins Zeitalter der Digital Data Intelligence katapultiert haben. Die Datenbestände sind erheblich gewachsen (und tun dies auch weiterhin), während die Kosten für Speichertechnologien gesunken sind. Gleichzeitig haben wir den unaufhaltsamen Aufstieg der softwareseitigen Datenanalyse und auf Seiten der Unternehmen ein wachsendes Bewusstsein für datengestützte Entscheidungen sowie für die Monetarisierung verwertbarer Informationen, die aus den vorhandenen Rohdatenbeständen gewonnen werden.

Moderne Tools für Business Intelligence (BI) und Big Data Analytics wie auch das Internet of Things sind in vielen verschiedenen Branchen bereits allgegenwärtig – ob Marketing, Finanztechnologien, Risikomanagement, Gesundheitswesen, Automobilbau, Handel oder sogar Biotechnologien und Umweltforschung.

Alle genannten Anwendungsfälle dienen demselben Ziel: der Erschließung verwertbarer Informationen aus Datenbeständen. Solche Initiativen betreffen dabei ein breites Spektrum von Abteilungen in Unternehmen: Anwendungsentwickler, Data Analysts und Data Scientists, aber auch Business Analysts und sogar Nutzer aus Fachbereichen.

Diesen Teams steht eine Vielzahl von Datenquellen zur Verfügung, die teils aus bestehenden Repositorys wie Data Warehouses und Data Marts stammen, teils mit neuen Ansätzen wie Data Lakes gewonnen werden. Das moderne Konzept der Data Lakes ist für die Speicherung riesiger Datenmengen unabhängig von Format und Inhalt ausgelegt. Derzeit beruhen Data Lakes in der Regel auf Hadoop-Speicher ohne vordefiniertes Schema, in dem Daten nach Herkunft kategorisiert abgelegt werden. Der wesentliche Zweck eines Data Lake besteht im Kombinieren von Datenquellen sowie in der Vermeidung von Datensilos.

Fünf wichtige Aspekte bei der Auswahl eines Wide Area Networks

Erfolgreiches Netz-Design kann die Produktivität deutlich verbessern und neue Chancen für die digitale Geschäftsentwicklung eröffnen. Ein unzureichend dimensioniertes WAN hemmt dagegen das produktive Arbeiten und führt zu Frustration bei Mitarbeitern, Lieferanten und Kunden. In diesem Whitepaper erfahren Sie, worauf es zu achten gilt.

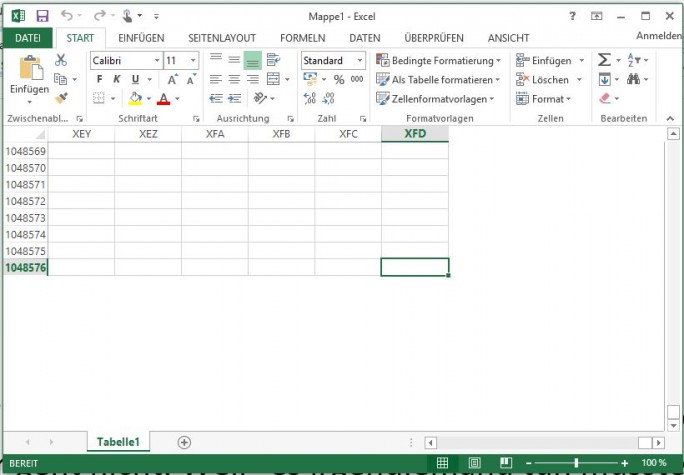

Gleichzeitig sollen die Datenhaltungskosten gesenkt und die Möglichkeiten zur Freigabe der Daten sowie zur teamübergreifenden Bearbeitung erweitert werden. Da die Zuständigkeit für das Erstellen, Befüllen, Steuern und Referenzieren dieser Quellen (und Data Lakes) bei den IT-Profis liegt, müssen wir heute feststellen, dass Nutzer aus dem Geschäftsbetrieb häufig Probleme haben, auf die Daten zuzugreifen und sie zu analysieren. Laut dem Marktforschungsinstitut Gartner verbringen Datenanalysten bis zu 80 Prozent ihrer Zeit mit der Datenaufbereitung. Dadurch werden Analyse und Entscheidungsfindung unnötig verzögert. Verbunden mit diesem Problem ist auch die Tatsache, dass viele Analysten traditionelle Tools wie Microsoft Excel nutzen, die weder die Menge noch die Vielfalt der neuen Datenquellen bewältigen können.

In einer modernen Welt muss man einfach erwarten können, dass Business Intelligence und Big Data Analytics von Nutzern in den Fachbereichen unkompliziert eingesetzt werden können. Dafür brauchen sie eine ergänzende Lösung, mit der sie den Wert der Daten auch ohne Unterstützung durch ihre IT-Teams voll ausschöpfen können. Gute Datenaufbereitungstools bieten Funktionen wie Datenermittlung, Inventare, Stichprobenentnahme, Datenanreicherung, Datenkombination und Filterung. Sie unterstützen verschiedene Datenmodelle und -strukturen und helfen auch bei der Erkennung von Beziehungen zwischen Attributen. Schließlich bieten sie Funktionen zum Kuratieren von Daten an, die beispielsweise die Aufrechterhaltung der Datenqualität gestatten.

Datenaufbereitungstools werden häufig von Mitarbeitern in den Abteilungen verwendet, weil sie eine zweckmäßige grafische Oberfläche mit leistungsfähigen Funktionen kombinieren. Zweck einer Datenaufbereitung, die als Self-Service-Funktion allen Nutzern im Geschäftsbetrieb zugänglich ist, sollte es sein, zeitlichen Aufwand und Komplexität bei der Datenermittlung zu reduzieren, die den Analyseprozessen vorangeht. Auf diese Weise kommt man deutlich schneller zur eigentlichen Entscheidung.

An dieser Stelle möchten wir drei wertvolle Tipps geben:

- Kommen Sie nicht auf die Idee, Daten in Excel-Dateien manuell bereinigen zu wollen – das ist reine Zeit- und Geldverschwendung.

- Nutzen Sie ein grafikbasiertes Tool, um Ihre Daten mithilfe einer benutzerfreundlichen Oberfläche auf die Analyse vorzubereiten.

- Speichern Sie Ihre für die Datenbereinigung verwendeten Prozesse und Methoden. So müssen Sie das Rad nicht jedes Mal neu erfinden.

Datenaufbereitung sollte keine Raketenphysik sein – es sei denn, Sie möchten tatsächlich zum Mond fliegen.

Talend kombiniert Datenaufbereitung und Datenintegration und bietet Geschäftsbetrieb und IT so ganz neue Möglichkeiten, Daten in aussagekräftige Informationen umzuwandeln. Talend Data Preparation als Bestandteil von Talend Data Fabric bietet der IT die volle Kontrolle beim Verwalten des Datenzugriffs und bei der Bereitstellung unternehmensweiter Kooperationsmöglichkeiten.

Mit Data Preparation kann jeder Nutzer vom Data Scientist bis hin zum Nutzer im Geschäftsbereich Daten mithilfe browserbasierter Point-and-Click-Tools abrufen und bereinigen. Das Dataset-Inventar gestattet zudem die unkomplizierte Verwendung von „Rezepten“ zur vollautomatisierten Bereinigung der Daten nach Änderungen am Bestand.

Die webbasierte Oberfläche von Talend Data Preparation und der Workflow der Software machen ihren Einsatz intuitiv und bieten den Benutzern intelligente Unterstützung beim Importieren, Strukturieren und Transformieren von Daten. Auch Benutzer ohne IT-Kenntnisse bringen Daten unkompliziert in die gewünschte Form, ohne komplexe Formeln erstellen, Programmcodes zu schreiben oder dieselben mühseligen Schritte immer und immer wieder durchführen zu müssen. Zu den wichtigsten Funktionen gehören die automatische Erkennung und Identifizierung von Inhalten, eine intelligente Vorschlagsfunktion, Möglichkeiten zur Bereinigung und Anreicherung von Daten sowie verschiedene Visualisierungsansätze, damit der Benutzer direkt mit der Datenanalyse beginnen kann. Die Software erlaubt außerdem das Speichern und Wiederverwenden wichtiger Formeln (so genannter „Rezepte“), um zukünftige Projekte noch stärker zu beschleunigen.

Solche Werkzeuge sind in der Lage, die notwendige Brücke zwischen IT-Projekten und Data Governance zu spannen.