KI auf dem Prüfstand

LLMs besitzen einerseits innovative neue Fähigkeiten, stellen Unternehmen allerdings auch vor diverse Herausforderungen: ob EU AI Act, Metriken oder Benchmarks zur Evaluierung von Modellen und Prompts.

Weiterhin sind generative Sprachmodelle mit neuartigen Risiken behaftet. Beispiele hierfür sind unbeabsichtigte Copyright-Verletzungen oder auch die ungewollte Verbreitung von Desinformation.

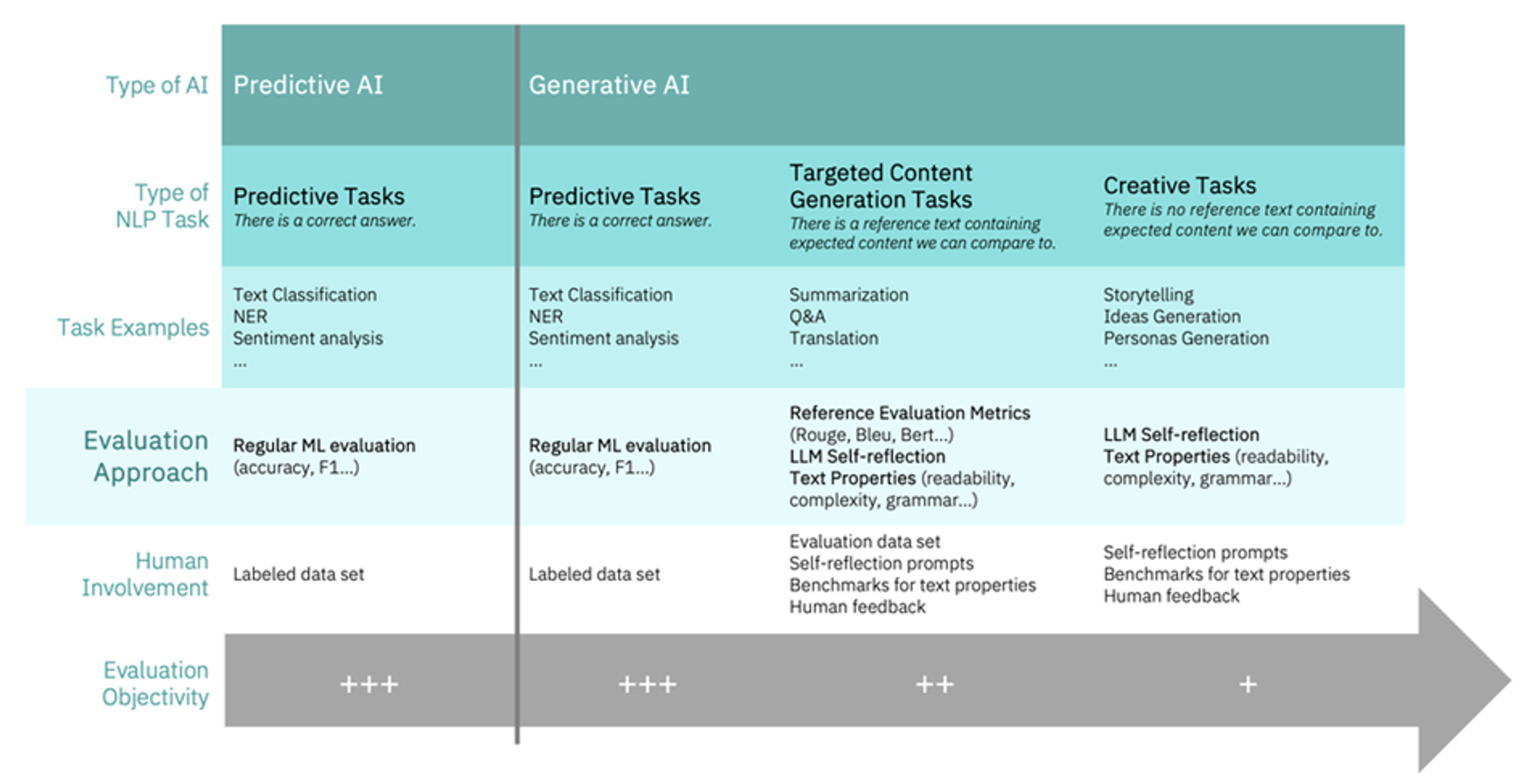

Bewertungsansätze für die Leistungsbewertung von LLMs

Benchmarks

Diese werden verwendet, um die bereichsübergreifende Leistung von Modellen anhand eines standardisierten Satzes von Aufgaben zu analysieren, wobei vorhandene Ground-Truth-Daten und ein vordefinierter Satz von Messgrößen genutzt werden.

Metriken

Diese quantifizierbaren Messgrößen beschreiben spezifische Eigenschaften der Modellausgabe, meist im Vergleich zu einem Referenztext. Sie werden verwendet, um die Leistung eines Modells hinsichtlich einer spezifischen Aufgabestellung zu bewerten.

Menschliches Feedback

Dies sind meist hochwertige Bewertungen von Experten in ihren jeweiligen Fachgebieten oder von beauftragten professionellen Gutachtern.

“LLM-as-a-judge“

Dieser automatisierte Ansatz verwendet LLMs zur Bewertung anderer LLMs. Jüngste Forschungsergebnisse zeigen, dass LLMs bei der Bewertung von Chatbots ähnliche Ergebnisse wie menschliche Bewerter erzielen können. Dieser Ansatz eignet sich auch für vollständig automatisierte LLM-Rankings. Experimente zeigen jedoch, dass die von LLMs erzeugten Bewertungen teilweise systematisch verzerrt sein können. Einflussfaktoren können hierbei beispielsweise die Reihenfolge sein, in der die zu bewertenden Texte dem Modell vorgelegt werden.

Geeignete Bewertungsansätze hängen größtenteils vom jeweiligen Anwendungsfall und Entwicklungsstadium des Modells/Prompts ab. Benchmarks werden eher während des Modellauswahlprozesses genutzt, während individuelle Metriken für die Leistungsbewertung hinsichtlich der konkreten Aufgabenstellung entwickelt werden.

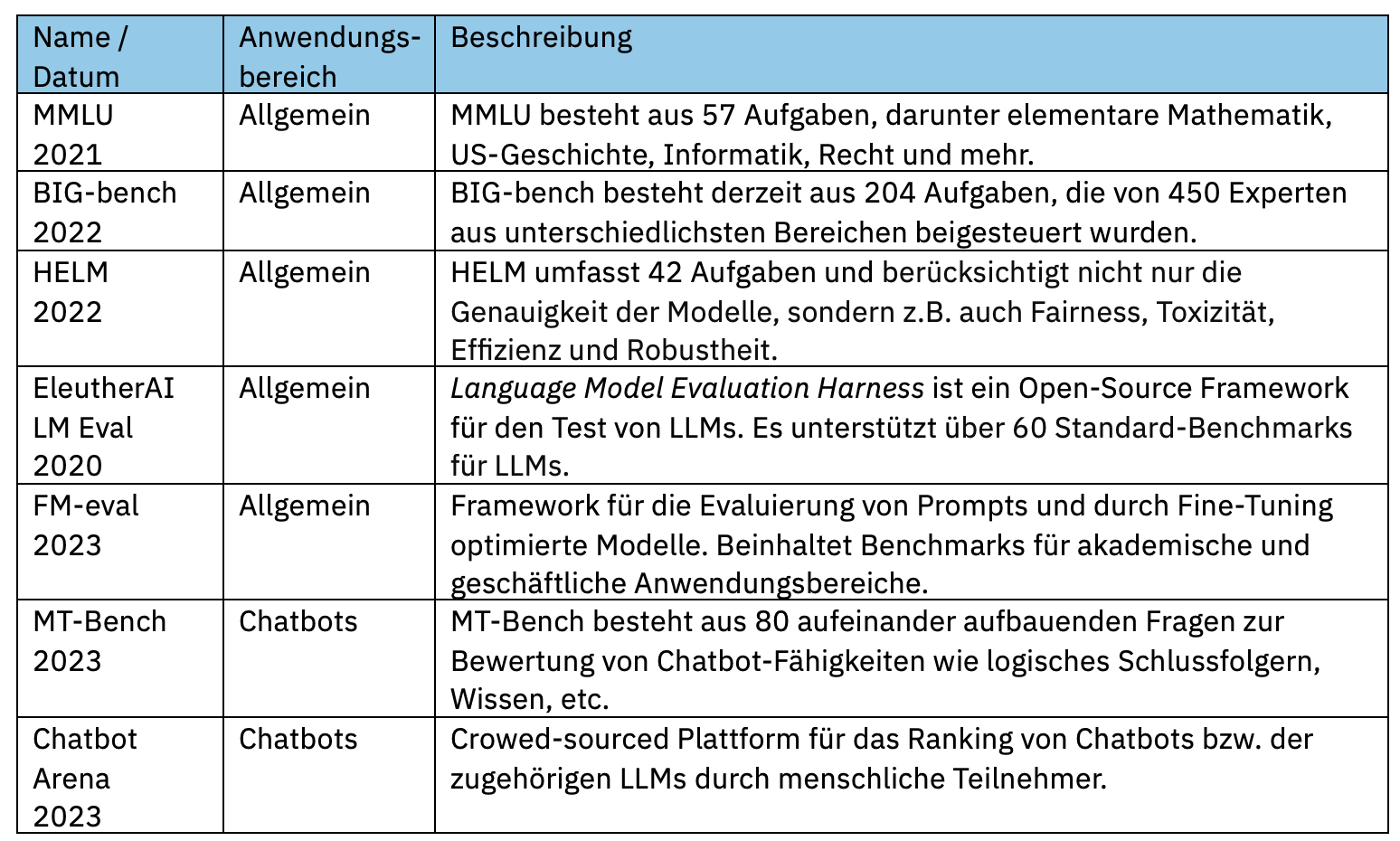

Benchmarks für die Bewertung von generativen Sprachmodellen

Obwohl aufgabenbasierte Benchmarks aktuell am gebräuchlichsten sind, entstehen auch andere Ansätze, um Schwachpunkte der traditionellen „Open Source multi-task“-Bewertungen anzugehen. Es lassen sich einige Benchmark-Gruppen beobachten.

Open-sourced multi-task Benchmarks

basieren typischerweise auf verschiedenen Aufgaben, für die Musterlösungen (Referenztexte) vorhanden sind und das Modell daran gemessen wird, wie nahe seine Ausgaben den Referenztexten kommen. Die Bewertung kann entweder mittels traditioneller, referenzbasierter Metriken erfolgen oder KI-gestützt unter Nutzung des „LLM-as-a-judge“-Konzepts – wie im Fall von AlpacaEval, das speziell für die Bewertung von chatbasierten LLMs entwickelt wurde. Eine besondere Kategorie sind Benchmarks für Embeddings, die bewerten, wie gut das Modell in der Lage ist, die semantische Bedeutung von Text in einem Vektorraum zu erfassen.

Preference-ranking Benchmarks

basieren auf dem Vergleich der von verschiedenen Modellen generierten Texte durch menschliche Bewerter, z.B. durch Experten in dem jeweiligen Aufgabengebiet oder durch Endanwender („crowdsourced“). Ein sehr bekanntes Beispiel hierfür ist Chatbot Arena.

Nicht-funktionale Benchmarks

sind noch relativ neu und befassen sich mit nicht-funktionalen Aspekten des Betriebs von LLMs in der Produktion, wie zum Beispiel der Geschwindigkeit der Token-Generierung oder der Transparenz der Modellentwicklung.

Geschlossene Benchmarks

sind Benchmarks, bei denen nicht alle Bewertungsverfahren offengelegt sind. Beispiele hierfür sind industrielle Benchmarks von vals.ai oder SEAL-Ranglisten. Diese Benchmarks versuchen eine der zentralen Herausforderungen traditioneller aufgabenbasierter Benchmarks anzugehen – das „Overfitting“: Wenn ein Modell mit öffentlich bekannten Benchmark-Aufgaben trainiert wurde, kann es zwar bei diesen Aufgaben außergewöhnlich gut abschneiden, aber diese Fähigkeiten sind möglicherweise nicht auf andere, realitätsnahe Aufgaben übertragbar.

Neben Datenlecks, die beispielsweise das Problem des Overfittings verursachen können, gibt es weitere Herausforderungen, die den praktischen Einsatz von Benchmarks für Unternehmensanwendungen einschränken können. Beispiele hierfür sind die Modellverfügbarkeit über verschiedene Benchmarks hinweg, Sprachbeschränkungen oder auch die begrenzte Anwendbarkeit der Benchmarks auf reale Szenarien. Aus diesen Gründen ist es für konkrete Anwendungen wichtig, benutzerdefinierte Bewertungsframeworks zu entwickeln, die sich auf den konkreten Anwendungsfall fokussieren und dafür geeignete Metriken sowie realistische Daten nutzen.

Referenz-basierte Metriken

Hier einige Anwendungsfälle, bei denen Metrik genutzt werden: Prompteentwicklung, Hyperparameter-Tuning, Performance-Monitoring, Bias- und Driftüberwachung (Bias und Drift sind Risiken, die mit generativen Sprachmodellen verbunden sind) oder auch die Bewertung der Gesamtqualität der generierten Texte. In der folgenden Übersicht konzentrieren wir uns auf referenzbasierte Metriken zur Bewertung der Textqualität hinsichtlich spezifischer Aufgabe wie beispielsweise der Textübersetzung. Die vom Modell generierten Texte werden mit

Referenztexten verglichen, die von Experten erstellt wurden. Je höher die Übereinstimmung mit dem Referenztext ist, desto höher ist der Metrikwert.

BLEU (Bilingual Evaluation Understudy)

ist eine ältere Metrik, die vor über 20 Jahren von IBM zur Bewertung computergenerierter Textübersetzungen entwickelt wurde. Sie misst die Übereinstimmung zwischen Segmenten (N-Grammen) des generierten Textes und des Referenztextes. Der Schwerpunkt liegt hierbei auf der Genauigkeit (Precision) der Übereinstimmung, d.h. generierte Text die ausschließlich Textfragmente enthalten, die im Referenztext auch vorgegeben sind, werden tendenziell hoch bewertet.

ROUGE (Recall-Oriented Understudy for Gisting Evaluation)

umfasst mehrere Metriken, die beispielsweise zur Bewertung von Textzusammenfassungen verwendet werden. Es wird u.a. untersucht, in welchem Maße die Textfragmente aus dem Referenztext wirklich auch alle im generierten Text enthalten sind. Der Schwerpunkt liegt also eher darauf, dass nichts vergessen wird (Recall).

Textvergleiche auf Basis von N-Grammen haben einige Einschränkungen. Texte, die in ihrer Bedeutung dem Referenztext sehr ähnlich sind, aber andere Formulierungen für die gleichen Fakten verwenden, werden tendenziell niedriger bewertet. Neuere Metriken wie BERTScore untersuchen nicht nur die Übereinstimmung spezifischer Textfragmente zwischen Referenztext und generiertem Text, sondern analysieren auch die semantische Ähnlichkeit. Außerdem wurden Variationen und Kombinationen der obigen Metriken entwickelt, um vorallem ihre individuellen Schwächen zu adressieren.

Anerkannte Standards für Modellbewertung fehlen

Referenzbasierte Metriken eignen sich besonders gut für die Bewertung der Leistung eines Modells oder seiner zugehörigen Prompts im Hinblick auf die spezifische Anwendung. Auf der anderen Seite können Benchmarks bei der initialen Auswahl von Modellen externer Anbieter hilfreich sein. Bei der Bewertung eines Modells sollte auch dessen Transparenz berücksichtigt werden: Liefert der Modell-Anbieter beispielsweise Informationen darüber, welche Trainingsdaten verwendet wurden und wie diese verarbeitet wurden?

Leider fehlen derzeit allgemein anerkannte Standards für die Modellbewertung. Es gibt jedoch erste Initiativen in diese Richtung, wie den Foundation Model Transparency Index (FMTI), der am Center for Research on Foundation Models (CRFM) in Stanford entwickelt wurde. Die kürzlich gegründete AI Alliance, ein Konsortium von Unternehmen, Forschungseinrichtungen und KI-Nutzern, zielt darauf ab, eine führende Rolle bei der Entwicklung von Bewertungsstandards zu übernehmen.

![]()

Hana Konrád

ist IBM Data Science Lead EMEA AI & Analytics.