Quantenrechner bereiten den Weg für komplexe Simulationen in bisher nicht dagewesenen Größenordnungen. Die mit ihnen erzeugten Quantenbits vermitteln Informationen effizienter als herkömmliche Bits und bieten damit ein riesiges Potenzial. Allerdings ergeben sich auch neue Hindernisse.

In der Wissenschaft und Wirtschaft existieren Aufgabenstellungen, an denen aktuelle Supercomputer bisher scheitern. Supercomputer basieren auf der Von-Neuman-Architektur, die nur die Zustände “0” und “1” kennt. Ein Bit, die kleinste Informationseinheit eines klassischen Rechners, weist einen dieser beiden Werte auf. Mit “0” und “1” lassen sich aber beispielsweise die Verkehrsströme in Großstädten nicht simulieren. Wie es funktionieren kann, die Bewegungen von 10.000 Taxis in Echtzeit zu erfassen, testet Volkswagen in Peking. Der Autokonzern setzt dazu Quantenrechner ein, um die Routen der Taxis und damit den Verkehrsfluss zu optimieren.

Auf welchem Leistungsniveau sich das Quantum-Computing bereits bewegt, demonstrierte Google Mitte 2017 auf einer Konferenz in München. Der IT-Konzern stellte den bis dato leistungsfähigsten Quantenprozessor vor, der über 20 Quantenbits (Qubits) verfügt. Qubits sind das Pendant zu den Bits von traditionellen Rechnern. Ein Qubit kann allerdings eine unbegrenzte Zahl von Werten annehmen, die ein Quantenrechner idealerweise parallel verarbeitet. Dadurch steigt die Ausführungsgeschwindigkeit spezieller Algorithmen exponentiell an.

Vor Google hielt IBM mit 17 Quantenbits den Bestwert. Seit 2016 bietet IBM Forschern über das Q Quantum Experience Project ran, auf einen Quantenrechner in der Cloud zuzugreifen. Der Zugang erfolgt über ein spezielles Software Development Kit und eine Schnittstelle für die Programmiersprache Python. Lange wird es nicht mehr dauern, bis CPUs 50 Qubits und mehr bereitstellen können.

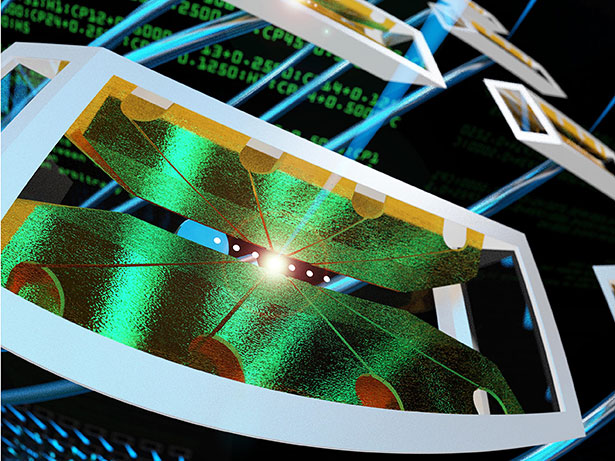

Mit Laser und Mikrowelle zum Qubit

Der Weg zum funktionierenden Quantenprozessor war kein einfacher. So wirkt sich das Messen der Position eines Qubits auf das Messergebnis aus – und kann es damit verfälschen. Mittlerweile gelingt es Forschern, Qubits über Laserstrahlenbeschuss von Atomen, Elektronen sowie Photonen kontrolliert zu erzeugen oder zu erfassen. Ein weiteres gängiges Verfahren verwendet Mikrowellen. Allerdings fehlt noch eine weitere Voraussetzung, um die Werte parallel zu berechnen: Die Verschränkung (Entanglement) von Quantenbits in einem Register. Dieser Quanteneffekt bezieht sich auf die Zustandsänderung eines Qubits, die sofort und unabhängig von der Entfernung bei allen mit-verschränkten Qubits eintritt. Dieser Änderungswert lässt sich messen und in “1” und “0” übersetzen.

Das Duplizieren von Qubits führt zu unterschiedlichen Versionen derselben Daten – das sogenannte „No-Cloning-Theorem“. Daraus resultiert, dass die üblichen Verfahren für die Fehlerkorrektur bei Quantensystemen nicht funktionieren. Das nötige mehrfache Speichern und Vergleichen der Daten gelingt nur auf “normalen” Rechnern. Die herkömmlichen Systeme sind zudem resistenter gegenüber gravierenden Hardwarefehlern, wie den “Blue Screen of Death” bei Windows-PCs. Dieser Fall tritt mit der verschwindend geringen Wahrscheinlichkeit von 10-24 ein. Die heute verfügbaren Quantenrechner erweisen sich hingegen wegen ihres komplexen Aufbaus und ihrer hohen Empfindlichkeit bei diesen Hardwarefehlern bis zu 20-mal so anfällig.

Aufwändige Technik, hohe Investition und praxisrelevante Alternativen

Als nachteilig erweist sich außerdem die aufwändige Technik. Eine führende Quanten-Technologie nutzt supraleitendende Materialien, die Kühlapparaturen auf Temperaturen von -273 °C bringen müssen. Das sensible System dürfen zudem keine äußeren Einflüsse wie Magnetfelder und Erschütterungen beinträchtigen. Die Anschaffungskosten bewegen sich deshalb selbst bei den preisgünstigsten Systemen derzeit im zweistelligen Millionen-Dollar-Bereich.

Das Entwickeln von Algorithmen und Programmiertechniken sowie das Bereitstellen von Entwicklungs-Tools stellen heute die Grundlagenarbeit dar, um später Quantentechnologie für Big Data, Künstliche Intelligenz und IT-Sicherheit einsatzfähig zu machen. Diesem Ziel hat sich unter anderem der IT-Spezialist Atos verschrieben, der dazu seine Quantum Learning Machine (Atos QLM) im Sommer 2017 vorstellte. Atos QLM nutzt einen speziellen, hoch kompakten Supercomputer, um darauf einen Quantenrechner zu simulieren. Appliances mit 30 bis 40 Qubits, die auf 1 bis 24 Terabyte Arbeitsspeicher zurückgreifen, stehen bereit. Das kleinste Modell kostet rund 100.000 Euro – und ist damit auch für Unternehmen und Forschungseinrichtungen erschwinglich, die über ein begrenztes Budget verfügen.

Transaktionen und Medikamente aus Quantentechnik

Der Finanzsektor wird investieren müssen, um Transaktionen besser abzusichern, sprich den finanzrelevanten Datentransfer zu verschlüsseln. Denn es ist davon auszugehen, dass sich mithilfe von Quantenrechnern herkömmliche Verschlüsselungstechniken aushebeln lassen. Dazu zählen auch Verfahren auf Basis elliptischer Kurven (Elliptic Curve Digital Signature Algorithm, ECDSA), mit denen Public und Private Keys von Block Chain geschützt werden. Einen Ausweg bieten Techniken wie die Quantum Key Distribution (QKD) in Verbindung mit Hardware-Sicherheitsmodulen. Damit lassen sich Schlüssel auf sichere Weise speichern und verteilen. Außerdem können Banken Quantum-Computing im Hochgeschwindigkeitshandel praktizieren. Mit maßgeschneiderten Algorithmen können Quantenrechner dadurch im Millisekunden-Takt entscheiden, wann sie am besten verkaufen oder kaufen sollen.

Weitere Einsatzfelder von Quantenrechnern sind Problemstellungen, bei denen eine große Zahl von Kombinationen und möglichen Lösungswegen gegeben ist. Dazu zählen die Optimierung von Versorgungsnetzen in der Strom- und Wasserversorgung, die Simulation des Faltvorgangs bei Proteinen, die Bildanalyse und Objekterkennung oder auch das maschinelle Lernen.

So sind Forscher daran interessiert, die Interaktionen von Molekülen genau zu beobachten. Mit normalen Rechnern ist das bisher nur bei einfachen Molekülen möglich. Google hat dagegen mithilfe seines Quantenrechners bereits komplexe Wasserstoff-Moleküle und deren Reaktion mit anderen Stoffen untersucht. Solche Daten sind wichtig, um beispielsweise neue Arten von Düngemitteln oder Medikamenten zu entwickeln.

Bessere Sturmprognosen und ihre Folgen

Die Analyse und Prognose von Klima- und Wetterdaten können Quantencomputern entscheidend verbessern. Mit ihnen sollte es gelingen, genauer den Weg vorherzusagen, den ein Wirbelsturm oder eine Unwetterfront nimmt. Je eher die Prognose vorliegt, umso gezielter lassen sich Evakuierungen und weitere Katastrophenschutzmaßnahmen einleiten. Der Sturm “Xavier” im Herbst 2017 in Deutschland hat klar vor Augen geführt: Selbst Großrechner schaffen es nicht, eine derartige Prognose zu liefern.

In dem Zuge dürften sich auch Versicherungsexperten für Quantum-Computing interessieren. Ihre angebotenen Versicherungstarife und Leistungen richten sich danach, welche Schäden entstehen können. Wo und wann Unwetter mit welcher Wahrscheinlichkeit auftreten, wären in diesem Kontext überaus nützliche Informationssätze für Versicherungsunternehmen.

Spitzenrechenleistung aus Hybrid-Ansatz und Cloud

Quantencomputing gehört die Zukunft, wobei sich die Experten über den genauen Zeitpunkt der Serienreife uneinig sind. Der Zugang zu Quantencomputern wird sich jedoch definitiv zu einem wichtigen Wettbewerbsfaktor entwickeln. Warum? Forschungseinrichtungen und Unternehmen stehen vor der Herausforderung, komplexe Simulationen durchzuführen, um sich zu profilieren. Bei solchen aufwendigen Berechnungen spielen Quantencomputer ihre Vorteile aus. Vor einer Investition sollten potenzielle Anwender bedenken, dass Quantenrechner nicht bei allen Aufgaben Spitzenleistungen bringen.

Für Standardaufgaben wie das Bearbeiten von E-Mails, Excel-Tabellen und das Desktop-Publishing reichen Systeme auf Basis der Von-Neumann-Architektur vollkommen aus. Konsequenterweise arbeiten Forscher bereits an einem Hybrid-Ansatz, um beide Rechnersysteme zu kombinieren. Auch gibt es Cloud-Modelle, um vielen Nutzern die Quanten-Technologie zugänglich zu machen. Die sehr aufwendige und teure Implementierung eines Quantenrechners im hauseigenen Rechenzentrum entfällt dadurch. Allerdings gilt es, die Daten und die Ergebnisse der Berechnungen, die in einem Quanten-Cloud-Datacenter durchgeführt wurden, vor dem Zugriff Unbefugter zu schützen. Auch hierbei kann die Quantentechnologie helfen.